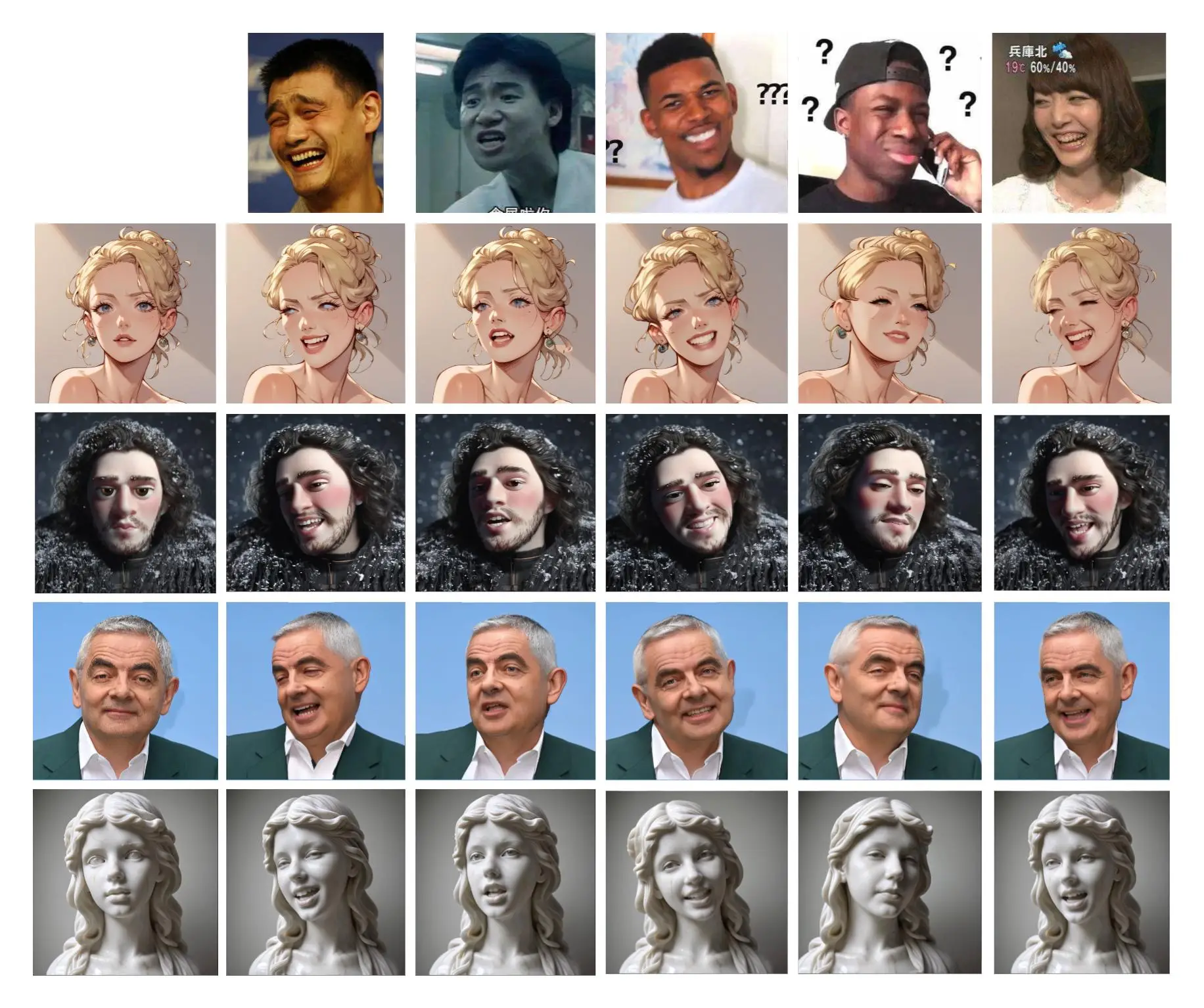

HelloMeme是一个专注于生成高保真图像和视频内容的ai项目,特别是表情克隆技术。这项技术基于SD1.5架构,支持ComfyUI,用户通过简单的操作就可以将一张图片的表情迁移到另外一张图片/视频上,生成效果超越了同类工具如Liveportrait。都可以用于AI数字人、表情包制作以及照片复活生成上。

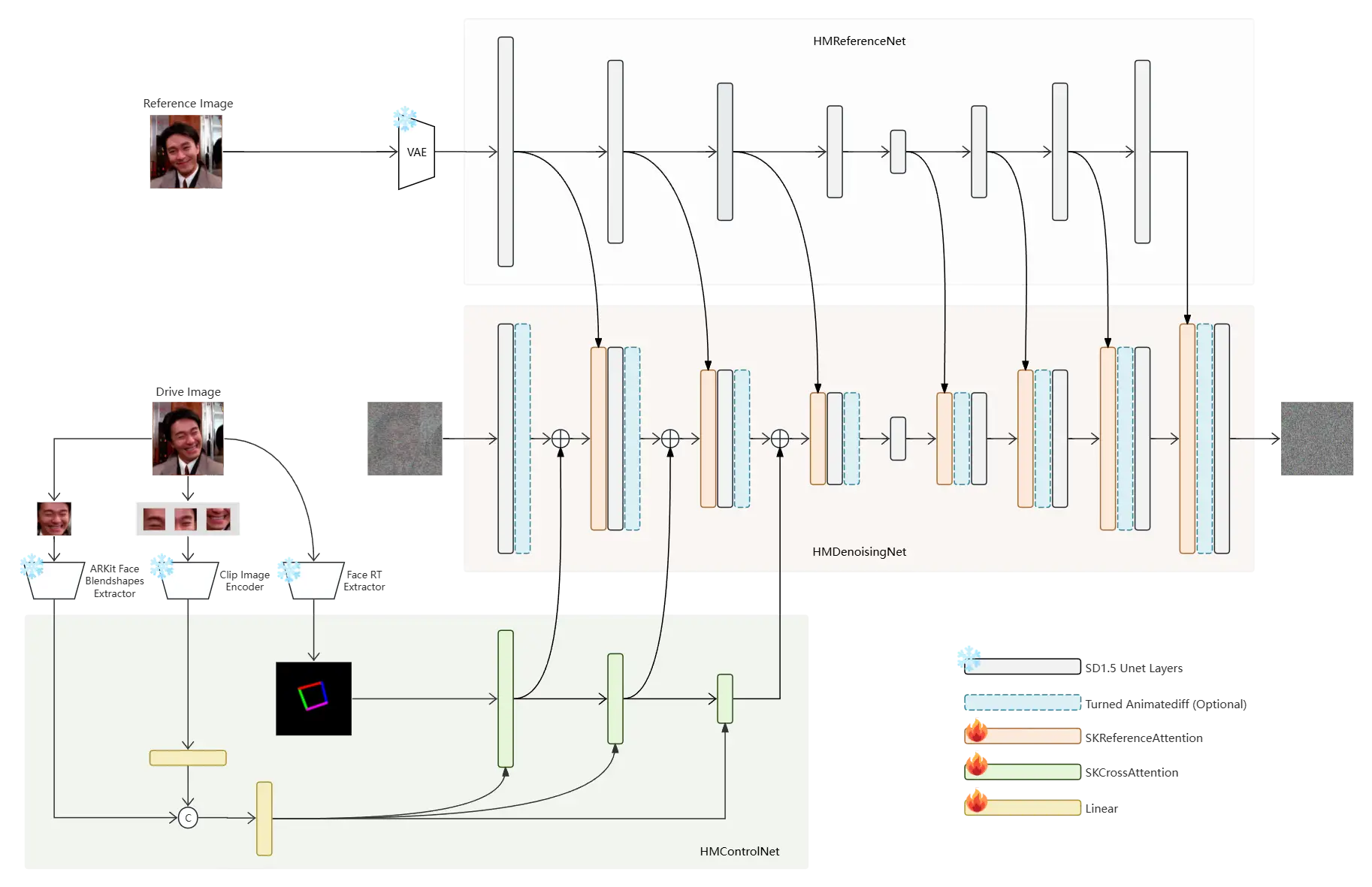

HelloMeme独特的地方就在于它空间编织注意力的扩散模型,使它能细微地处理图像和视频中的面部表情,从而在静止图像和动态视频中转化出更加圆滑细腻自然的表情。

HelloMeme核心功能:

表情转移:HelloMeme能够将一个人的面部表情准确地转移到另一个个体的面部,并且能够保持面部表情高度的一致性,对于数字内容创作、虚拟角色动画以及个性化视频制作来说,具有非常大的意义。

兼容易用性:它与SD1.5生态系统的兼容性意味着用户可以利用现有的LoRa或Checkpoint资源,通过ComfyUI界面轻松操作,无需复杂的编程知识。

技术架构:HelloMeme采用了集成空间编织注意力的扩散模型,这在AI生成内容领域是一个创新点,它优化了图像和视频生成过程中的细节处理,提高了生成内容的质量。

HelloMeme ComfyUI V2 最新更新

主要改进:

改进了生成视频与驱动视频之间的表情一致性。

优化了算法,增加了VAE选择功能和超分辨率功能。

新增了HMControlNet2模块,优化了VRAM使用。

提供了简化的HMVideoSimplePipeline,适用于VRAM较少的设备。

HelloMeme新功能:

引入了表情增强模块,使生成的面部表情动作更加圆滑细腻。

如何使用HelloMeme进行视频生成?

准备环境:确保您的计算机上安装了Python和必要的库。HelloMeme支持PyTorch和FFmpeg,您需要安装这些依赖项。

克隆代码库:从GitHub上克隆HelloMeme项目代码。可以使用以下命令:

git clone https://github.com/HelloVision/HelloMeme

cd HelloMeme

安装依赖:在项目目录下,创建一个新的Python环境并安装所需的库。可以使用以下命令:

pip install diffusers transformers einops opencv-python tqdm pillow onnxruntime onnx safetensors accelerate

准备输入文件:您需要准备一个参考图像和一个驱动视频。参考图像用于提取特征,而驱动视频则用于生成新的视频内容。

运行视频生成脚本:使用inference_video.py脚本来生成视频。在终端中输入以下命令:

python inference_video.py

该脚本会处理输入文件并生成输出视频。

查看结果:生成的视频将保存在指定的输出目录中,您可以查看并下载这些文件。

关键模块介绍

HMReferenceNet:从参考图像中提取高清特征。

HMControlNet:提取面部信息,如头部姿势和表情。

HMDenoisingNet:负责去噪并生成最终的视频帧。

HelloMeme的出现,不仅提升了AI生成视频的稳定性与自然度,还可能对娱乐、广告、教育等多个领域产生深远影响,特别是在需要高质量数字内容的场景中。